[인더스 체인저] ③ “엔비디아 잡아라”…反동맹군 AI 가속 웨이브

- 가

- 가

미중 패권경쟁과 국지적 충돌로 인해 글로벌 정세가 시시각각 빠르게 변화하고 있다. 이에 따라 전통적 산업군 역시 그 경쟁양상이 하루가 다르게 바뀌고 있다. 미래 핵심 경쟁력으로 꼽히는 반도체를 시작으로 디스플레이, 이차전지 등 공급망 확보가 무엇보다 중요한 난제로 꼽힌다. 또한 AI를 시작으로 소부장 기업뿐만 아니라 제조사까지 신규 시장 선점에 열을 올리고 있다. 이에 <디지털데일리>는 19주년을 맞이해 산업군을 뒤바꾸는 주요 요소들을 살펴보고 그에 따른 변화 양상을 짚어보고자 한다. <편집자주>

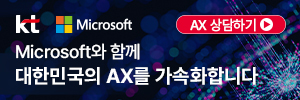

엔비디아 젠슨 황, ‘GTC 2024’서 생성형 AI, 가속 컴퓨팅, 로보틱스 분야 최신 혁신 공개 [사진=엔비디아]

[디지털데일리 김문기 기자] AI 반도체 시장에서 엔비디아가 승기를 잡은 가운데, 올해 글로벌 거대 IT 공룡들을 중심으로 시장 재편이 예상된다. 인텔과 AMD, 삼성전자 등이 시장 공략에 적극 나섬에 따라 경쟁 판도가 흔들리고 있는 것. 특히 거대 AI 근간을 이루는 AI 반도체 기반 AI 가속기 시장을 두고 주요 기업들의 합종연횡이 계속되면서, 개인전이 아닌 단체전 양상을 띄고 있다. 어제의 적이 오늘의 동지가 되는 일 또한 허다해 경쟁 양상도 시시각각 달라지는 모양새다.

시장조사업체 옴디아에 따르면 AI 반도체 중 추론용 반도체 시장 규모는 지난해 60달러(한화 약 8조원)에서 오는 2030년 1430억달러(한화 약 194조원)에 이를 전망이다. 또 다른 시장조사업체 욜인텔리전스는 AI 가속기 공급량이 지난해 약 400만대 규모에서 올해 800만대 규모로 2배 가량 성장할 것으로 내다봤다. 대부분의 지표가 우상향을 가리키고 있는 가운데, 시장 확장에 따른 선점 효과를 누리고자 하는 기업들의 행보도 보다 빨라지고 있다.

특히나 AI 가속기 시장에서 엔비디아는 막강한 영향력을 행사하고 있다. 업계에 따르면 엔비디아는 AI 가속기 시장에서 무려 90% 가량의 점유율을 보유하고 있는 것으로 알려졌다. 수요 대비 공급량이 부족해 없어서 도입하지 못한다는 탄식까지 흘러 나온다.

올해 경쟁 기업들은 이같은 엔비디아의 빈틈을 파고 들었다. 성능 우위뿐만 아니라 원활한 공급으로 인한 소위 가성비를 앞세우고 있다. 쿠다(CUDA) 기반의 엔비디아 생태계 역시 개방형으로 보편화하면서 맞서고 있다.

저스틴 호타드 수석 부사장 및 인텔 데이터센터 및 AI 그룹 총괄은 지난 4월 9일 개최된 인텔 비전 2024에서 “ “끊임없이 진화하는 AI 시장 환경 속에서 현재 제공되는 제품에는 상당한 격차가 존재한다. 고객과 시장의 피드백에 의하면 선택의 폭이 확대되길 바라는 요구가 있다”라며 “기업은 가용성, 확장성, 성능, 비용, 에너지 효율성 등을 비중있게 고려한다”고 진단했다. 적시에 제공되는 제품일수록 성능뿐만 아니라 확장성 등에 이점이 있다는 발언이다. 특히 인텔은 이날 엔비디아 H100을 저격해 인텔 신규 AI 가속기의 성능 우위를 자랑하기도 했다.

김홍필 AMD 코리아 데이터센터 및 클라우드 솔루션 아키텍트 이사 역시 지난 3월 국내 간담회를 통해 “시장에서 엔비디아 쏠림 현상이 강하다는 사실은 알고 있다”라고 인정하면서도 “우리 제품은 5월부터 본격적으로 고객에게 전달된다”고 물량 공급에 문제가 없음을 재차 강조하기도 했다.

특히, 이 두 글로벌 기업은 국내 유수 기업들에 손을 내밀고 있다. AI 가속기의 핵심인 HBM의 경우 삼성전자, SK하이닉스와 협력하면서도 AI 생태계 확대까지 염두에 둔 행보다.

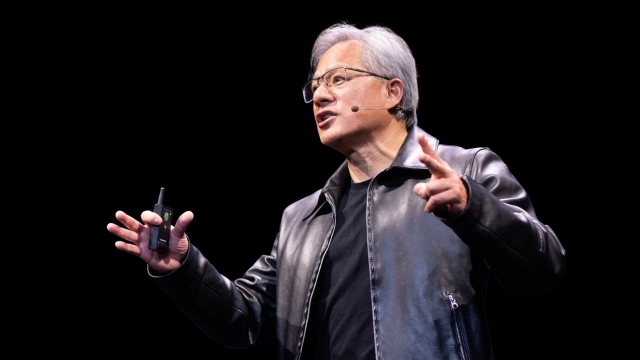

인텔 비전 2024에서 팻 겔싱어 인텔 CEO가 인텔 가우디 3 가속기를 소개하고 있다 [사진=인텔]

'韓 러브콜' 인텔, 가우디3 출전

인텔은 지난해 4월 차세대 AI 가속기 ‘가우디3’를 공개하며, 네이버를 전면에 내세웠다. 팻 겔싱어 인텔 CEO는 네이버에 대해 “불과 몇 년 전까지만 해도 그들에 대해 들어 본적이 없었다. 하지만 갑자기 그들이 업계에서 가장 빠르게 성장하는 아시아 클라우드 서비스 제공업체 중 하나이며, 현재 인텔의 거대한 파트너라는 점을 깨달았다”고 소개했다.

하정우 네이버 퓨처 AI센터장은 “고성능과 비용 효율적인 가우디 가속기를 통해 네이버가 AI 비전을 어디에서나 구현할 수 있다는 주요 목표를 달성케 할 것”이라고 화답했다.

인텔은 네이버뿐만 아니라 카이스트와도 손을 잡았다. 네이버와 인텔, 카이스트 AI 공동연구센터를 설립하기로 했다. 가우디를 최적의 환경에서 구동하기 위해 오픈소스용 소프트웨어 개발 등을 목적으로 한다. 국내 대학에 공동연구센터를 설립하고 지원하는 것은 카이스트가 처음이다.

김정호 카이스트 교수는 “KAIST는 가우디 시리즈의 활용을 통해 인공지능 개발, 반도체 설계와 운영 소프트웨어 개발 등에서 기술 노하우를 확보할 수 있다”라면서, “특히 대규모 인공지능 데이터센터 운영 경험과 향후 연구개발에 필요한 인공지능 컴퓨팅 인프라를 확보할 수 있다는 점에서 이번 공동연구센터 설립이 매우 큰 의미가 있다”라고 강조했다.

인텔이 공개한 ‘가우디3’는 대규모 언어 모델(LLM) 및 멀티모달 모델에서 AI 학습 및 추론을 위한 성능과 생산성을 대폭 향상했다. 기존 모델 대비 BF16용 AI 컴퓨팅에서 4배, 메모리 대역폭에서 1.5배, 대규모 시스템 확장을 위한 네트워킹 대역폭은 2배 올랐다. 5나노미터(nm) 공정으로 제조된다. MME(Matrix Multiplication Engine), 텐서 프로세서 코어(TPC), 네트워킹 인터페이스 카드(NIC) 등 모든 엔진을 병렬로 활성화할 수 있도록 설계됐다.

인텔은 엔비디아 H100 대비 평균적인 비교 성능을 게재했다. 라마(Llama2) 70억개 및 130억개의 매개변수와 GPT-3 1750억개의 매개변수 모델에서 학습 시간 50% 단축, 라마 70억개 및 700억개의 매개변수 모델에서 50% 빠른 추론 처리량(스루풋) 및 40% 향상된 추론 전력 효율성을 제공한다고 주장했다. 라마 70억개 및 700억개 매개변수와 팔콘(Falcon) 1800억개 매개변수 모델에서 엔비디아 H200 대비30% 빠른 추론이 가능하다고 자신했다.

가우디 3 가속기는 올 2분기 범용 베이스보드 및 개방형 가속기 모듈(OAM)의 산업 표준 구성으로 OEM에 제공될 예정이다. 가우디 3를 시장에 출시할 주요 OEM 업체는 델 테크놀로지스(Dell Technologies), HPE, 레노보(Lenovo), 슈퍼마이크로(Supermicro) 등이다. 인텔 가우디 3 가속기의 GA(General availability)는 올 3분기로 예정됐다. 인텔 가우디 3 PCIe 애드인 카드는 올해 4분기 출시된다.

리사 수 AMD CEO가 생성형 AI를 위한 가속기 AMD 인스팅트 MI300를 직접 공개했다

AMD, MI300 출사표

AMD는 지난해부터 AI 가속기 열풍에 적극 대응했다. 지난해 6월 개최된 ‘AMD 데이터센터&AI 테크놀로지 프리미어’를 통해 AMD 인스팅트 MI300X를 포함한 가속기 포트폴리오를 모두 공개했다. 이 제품군은 지난해말부터 시장에 풀리기 시작했다. 올 상반기 중 수요 대비 공급량을 보다 늘릴 예정이다.

‘인스팅트 MI300X’ 가속기는 AMD CDNA 3 아키텍처 기반으로 최대 192GB의 HBM3 메모리를 지원해 대형 언어 모델(LLM) 훈련과 생성형 AI 워크로드에 필요한 컴퓨팅 및 메모리 효율성을 제공한다. 대용량 메모리를 지원해 단일 가속기에 매개변수가 400억 개인 팔콘-40(Falcon-40)과 같은 대형 언어 모델을 수용 가능하다.

아울러 ‘AMD 인스팅트 플랫폼’은 8개의 MI300X 가속기를 산업 표준 디자인으로 결합해 향상된 AI 추론 및 훈련을 위한 솔루션을 지원한다.

MI300 시리즈를 직접 공개한 리사 수 AMD CEO는 “CDNA3는 인스팅트 가속기의 기본적인 아키텍처로 AI와 HPC 워크로드를 위해 특별히 설계됐다”라며, “새로운 컴퓨팅 엔진, 최신 데이터 형식, 5나노 또는 6나노미터 공정 기술, 가징 진보된 트리플A 패키징 기술을 사용하는 완전히 새로운 아키텍처”라고 강조했다.

빅터 펭 AMD 사장은 “AMD의 최첨단 기술로 탄생한 인스팅트 MI300 시리즈 가속기는 압도적 성능을 바탕으로 향후 대규모 클라우드 및 기업 배포에 활용될 것"이라며 “클라우드 서비스 제공업체나 OEM 및 ODM은 AMD가 제시하는 하드웨어와 소프트웨어 및 개방형 생태계 접근 방식을 활용해 기업이 AI 솔루션을 도입하고 배포할 수 있도록 지원한다”고 말했다.

AMD 역시 인텔과 마찬가지로 개방형 생태계에 주목하고 있다. 지난해말 생성형 AI, 특히 대규모 언어 모델에 최적화된 AMD 인스팅트 GPU용 오픈 소스 소프트웨어 스택인 ROCm 6의 최신 버전을 공개했다. ROCm 6는 새로운 데이터 유형, 고급 그래프 및 커널 최적화, 최적화된 라이브러리 및 강력한 어텐션 알고리즘을 지원한다. 라마 2 기준 텍스트 생성 전체 대기 시간을 비교하면, ROCm6를 MI300X에서 구동 시 MI250에서 실행되는 ROCm 5 대비 최대 8배 향상된 성능을 제공한다.

경계현 삼성전자 DS부문장 사장 [ⓒ연합뉴스]

엔비디아 '블랙웰', 삼성전자 '마하1'

엔비디아는 경쟁사의 도전에 맞서 지난 3월 개최된 GTC 2024에서 신규 가속기를 공개했다.

블랙웰 아키텍처 기반의 ‘B200’으로 명명된 새로운 GPU는 전작 대비 2배 가량 향상된 2080억개 트랜지스터로 구성됐으며, 밀접한 두개의 다이로 구성된 칩렛 구조를 갖추고 있다. 엔비디아는 이 플랫폼 자체를 ‘블랙웰 GPU’라 부른다. 두개의 GPU 칩은 10TB/s NV-HBI 연결을 통해서 마치 단일칩처럼 동작할 수 있도록 설계됐다. TSMC의 개선 버전인 4NP 공정이 도입됐다.

B200은 Arm 기반 단일 그레이스 CPU를 결합해 ‘GB200’으로도 제공된다. 이 플랫폼은 거대언어모델(LLM) 추론 성능을 전작 대비 30배 빠른 속도를 보여준다. 엔비디아에 따르면 비용과 에너지 소비를 최대 25배까지 줄여준다는 설명이다. GB200 플랫폼을 36개 조합해 설계한 모델이 ‘DGX GB200’이다. 이 시스템은 ‘GB200’ 슈퍼칩이라 부르는데 엔비디아 NV링크를 통해 하나의 슈퍼 컴퓨터처럼 연결해 사용할 수 있다.

젠슨 황 엔비디아 창립자 겸 CEO는 "엔비디아는 지난 30년 동안 딥 러닝, AI와 같은 혁신을 실현하기 위해 가속 컴퓨팅을 추구해 왔다. 생성형 AI는 우리 시대를 정의하는 기술이다. 블랙웰 GPU는 이 새로운 산업 혁명을 구동하는 엔진이다. 세계에서 가장 역동적인 기업들과 협력해 모든 산업에서 AI의 가능성을 실현할 것이다”라고 목소리를 높였다.

다만, 블랙웰 기반 AI 가속기 출시는 올해말 가능할 것으로 보인다. 그 사이 인텔과 AMD 등 경쟁사들이 얼마만큼 점유율을 높일 수 있는 지가 관건이다.

국내서는 삼성전자가 네이버와 손잡고 AI 가속기인 ‘마하1’ 개발에 뛰어 들었다. 전담팀도 구성하는 등 관련 사업에 속도를 높이고 있다. 사피온, 리벨리온, 퓨리오사AI 등 서드파티에서의 도전도 눈길을 끈다. 이밖에 구글과 오픈AI 등도 자체 AI 반도체 개발에 열을 올리고 있다.

당신이 좋아할 만한 뉴스

많이 본 기사

연재기사

실시간 추천 뉴스

-

[NSIS 2025] 아톤 "양자컴 상용화는 SF 아닌 현실…PQC로 예방"

2025-05-20 18:15:08 -

6월부터 비영리법인·가상자산거래소, 가상자산 매도 허용… 고객확인 강화

2025-05-20 17:42:37 -

작년 하반기부터 '가상자산' 불붙었다… 시가총액·원화예치금 급증

2025-05-20 17:29:46 -

카카오엔터 장윤중 공동대표, 빌보드 '2025 글로벌 파워 플레이어스' 선정

2025-05-20 17:15:13 -

[DD퇴근길] 지브리 프사로 촉발된 'AI 저작권'…"법·정책 논의 필요해"

2025-05-20 17:15:02